Depuis peu, les développeurs commencent à se faire à l'idée que les assistants de codage IA, comme GitHub Copilot, sont devenus leurs nouveaux meilleurs amis.

Mais voilà, des alternatives open-source émergent et il semble que la révolution libre est en marche !

Qu'est-ce que DeepSeek-Coder-V2 ?

DeepSeek-Coder-V2 est un modèle de langage de code open-source de type Mixture-of-Experts (MoE) qui rivalise avec les performances de GPT-4 sur des tâches spécifiques au code. Conçu pour aider les développeurs, ce modèle présente plusieurs caractéristiques essentielles :

Multilingue : formé à la fois au code et au langage naturel dans plusieurs langues, y compris l'anglais et le chinois, ce qui le rend polyvalent pour les équipes de développement internationales.

Polyvalent : il prend en charge une gamme étendue de plus de 338 langages de programmation, ce qui lui permet de s'adapter à divers environnements et besoins de codage.

Grande échelle : Pré-entraîné sur des trillions de tokens de code et de données textuelles, ce qui améliore ses capacités de compréhension et de génération dans divers scénarios de codage.

Plusieurs tailles : Les modèles sont disponibles en plusieurs tailles, ce qui permet aux développeurs de choisir celle qui correspond le mieux à leurs ressources informatiques et aux exigences de leur projet.

Vous pouvez accéder au modèle sur le site web de DeepSeek, qui propose un accès payant à l'API et un chat. Le code source est disponible sur GitHub et l'article de recherche est hébergé sur arXiv.

Les modèles sont hébergés sur Huggingface - cependant, vous avez besoin d'un matériel de niveau recherche pour exécuter les modèles localement en raison de leur taille.

Un Nouveau Joueur en Scène : DeepSeek-Coder-V2

Imaginez un modèle open-source robuste, conçu spécifiquement pour les tâches liées au code, qui offre des performances comparables à celles de GPT-4 en matière de génération, de complétion et de compréhension du code. C'est exactement ce que propose DeepSeek-Coder-V2 !

Comparaisons de DeepSeek-Coder-V2

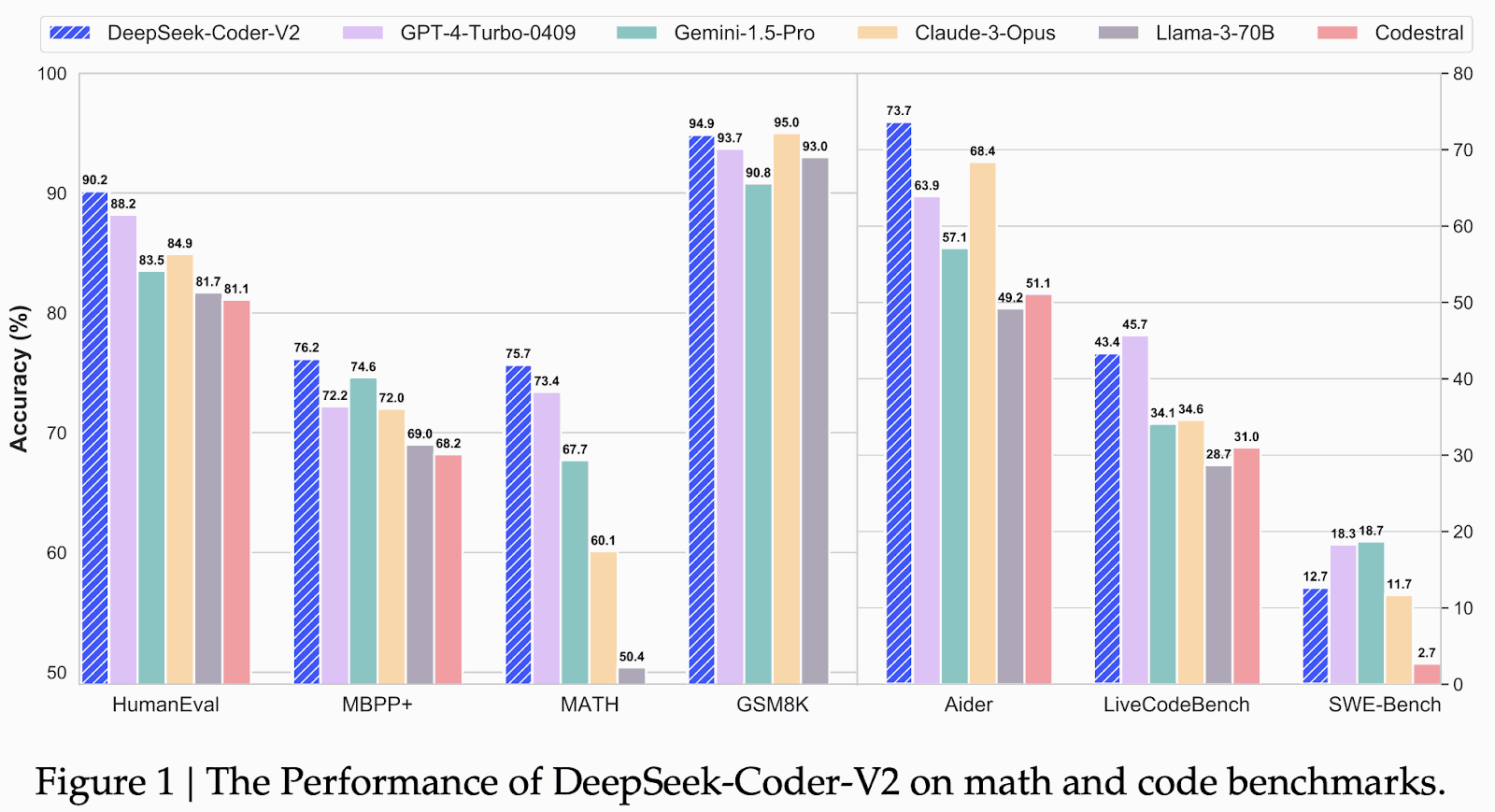

Voyez comment DeepSeek-Coder-V2 se comporte dans les benchmarks et comment il se compare à des modèles comme GPT-4 Turbo, Gemini 1.5 Pro, Claude 3 Opus, LLaMA 3-70B, et Codestral.

Foctionnement de DeepSeek-Coder-V2

DeepSeek-Coder-V2 s'appuie sur les fondements du modèle DeepSeek-V2, en utilisant une architecture sophistiquée de mélange d'experts (MoE) pour atteindre une haute performance dans les tâches spécifiques au code. Ce modèle s'appuie sur plusieurs modèles d'experts, chacun spécialisé dans différentes tâches de codage, et sélectionne dynamiquement l'expert le plus pertinent en fonction du code d'entrée. Cette approche améliore l'efficacité et la précision du modèle.

Le processus de formation de DeepSeek-Coder-V2 comporte plusieurs éléments essentiels. Il est pré-entraîné sur un ensemble de données complet comprenant 60 % de code source, 10 % de corpus mathématique et 30 % de corpus de langage naturel, soit un total de 10,2 trillions de tokens. Cet ensemble de données diversifié permet au modèle de comprendre et de générer efficacement du code. L'ensemble de données de code source comprend 1 170 milliards de jetons provenant de GitHub et CommonCrawl, couvrant 338 langages de programmation, ce qui représente une expansion significative par rapport aux modèles précédents.

Essayez DeepSeek-Coder-V2

DeepSeek-Coder-V2 est un atout notable comme assistants de codage open-source.

Vous pouvez exécuter le modèle localement, apprenez comment.

Similaire à "ChatGPT", avec recherche sur le Web et génération d'images intégrée en plus... Sagittarius propose désormais un accès à ce modèle à ses occupants ;)

Pour ceux qui s'intéressent à l'architecture sous-jacente, le modèle DeepSeek-V2, sur lequel DeepSeek-Coder-V2 est basé, introduit des innovations telles que Multi-head Latent Attention (MLA) et le cadre DeepSeekMoE. Des innovations qui contribuent à une inférence efficace, comme le détaille l'article de DeepSeek-V2 disponible sur arXiv.

DeepSeek-Coder-V2 : Vive leLibre

Le rival "open-source" de GPT-4, Gemini 1.5 Pro, Claude 3 Opus, Llama 3 70B, ou Codestral.