Les réseaux sociaux publics, les sections de commentaires et les forums de discussion sont en panne. L'internet promettait un accès illimité à la connaissance et à des conversations réfléchies et intelligentes avec des personnes du monde entier. Au lieu de cela, nous avons des trolls, des manipulateurs, de l'indignation et du spam.

On pourrait penser que la décentralisation aggraverait ces problèmes. Après tout, la plupart des réseaux sociaux décentralisés ou non modérés se transforment au fil du temps en un feu de poubelle de contenu de mauvaise qualité. En l'absence de modérateurs ou de la menace d'être banni, les pires utilisateurs se sentent enhardis à diffuser leurs bêtises sur l'ensemble du réseau. Au fur et à mesure que la qualité se dégrade, les meilleurs utilisateurs se détournent du réseau et celui-ci devient moins utile et moins attrayant.

Mais il existe une solution qui redonne le pouvoir aux gens, en leur permettant de modérer leur propre monde, en travaillant avec leurs amis pour le préserver des discours peu réfléchis. Cette solution fonctionne en reflétant le monde réel : donnez à chacun une réputation et la possibilité d'ignorer ceux qui ont une mauvaise réputation.

Dans cet article, je vais montrer non seulement comment un système de modération décentralisé peut être aussi bon que les systèmes existants, mais aussi les dépasser, en créant un réseau social de plus grande qualité.

Mais d'abord, prenons un peu de recul et voyons ce que la modération centralisée a de mauvais.

La modération centralisée et ses défauts

La modération centralisée fait référence aux réseaux sociaux ou aux forums où une entité centrale, telle qu'une société ou le propriétaire du site, a le pouvoir exclusif de modérer les contenus. Il existe généralement un ensemble de règles que tous les utilisateurs doivent suivre. Si elles ne sont pas respectées, le contenu de l'utilisateur est supprimé et les récidivistes sont bannis.

Les défauts se situent au niveau du contenu que certains utilisateurs apprécient et d'autres pas, et de la manière de traiter ce contenu.

Avec une modération centralisée, nous devons tous respecter les mêmes règles, et les sites doivent donc faire de leur mieux. S'ils sont trop sévères dans leur modération, ils auront un bon rapport signal/bruit, mais le contenu risque de devenir trop partisan ou ennuyeux. S'ils sont trop indulgents, le contenu deviendra plus bruyant, ce qui le rendra moins agréable, car il y aura alors plus de messages à faible impact à trier. Et certains des pires contenus rebuteront de nombreuses personnes.

Spectre de contenu

Imaginez que vous évaluez chaque élément du contenu des médias sociaux selon un spectre de contenu comme suit :

Basse qualité → Haute qualité

Faible offense → Forte offense

Précision → imprécision

Considérez où le contenu que vous appréciez le plus se situe sur ces spectres. Ce n'est probablement pas un point fixe, mais plutôt une fourchette de ce qui est considéré comme acceptable et une fourchette plus petite de ce qui est considéré comme idéal.

Le pire contenu se situe généralement à l'extrême de ces spectres. Les spams sont de très mauvaise qualité, les haineux sont très offensifs et les manipulateurs sont souvent inexacts.

Un site présente donc un bon rapport signal/bruit lorsqu'un bon pourcentage de son contenu se situe dans la zone idéale.

Les utilisateurs veulent voir du contenu qui se situe dans leur zone idéale, plutôt que d'avoir à entendre l'opinion de tout le monde. S'il y a trop de contenu en dehors de leur zone idéale, ils se lasseront souvent et quitteront le site.

Parfois, une modération importante du contenu qui sort de la "zone idéale" est une bonne chose, car cela signifie que vous apprécierez davantage le contenu que vous lisez, sans devoir passer par un contenu purement acceptable.

Le principal défaut des réseaux centralisés est qu'en établissant un ensemble de règles auxquelles tous les utilisateurs doivent se conformer, les sites prédéfinissent le spectre de contenu admissible. Ce spectre de contenu détermine non seulement le type d'utilisateurs qui seront autorisés sur le site, mais aussi ceux qui seront attirés par le site, car les utilisateurs dont le spectre de contenu correspond le plus au site auront tendance à rester plus longtemps.

Il s'avère que les services centralisés ont réfléchi à ce problème au cours de la dernière décennie et ont trouvé une solution : des flux déterminés par des algorithmes. Si chacun a son propre flux, un algorithme d'IA peut apprendre quel est le spectre de contenu idéal d'une personne et lui montrer le contenu qui lui convient le mieux. Ce flux est un filtre sur le monde qui aide à voir le site sous un angle "idéal".

Les flux déterminés par des algorithmes sont la prochaine étape de l'évolution des réseaux sociaux, mais ces flux présentent leur propre lot de problèmes.

Le problème des flux choisis par un algorithme

Le fait d'avoir un flux social piloté par un algorithme peut être utile pour faire apparaître tout le contenu que vous aimeriez voir le plus souvent sur un réseau social, mais il a aussi des côtés sombres auxquels on pense rarement.

Le plus gros problème de l'utilisation d'algorithmes pour personnaliser les flux sociaux est que l'utilisateur n'a aucune idée des décisions prises par l'algorithme. Avec l'essor des réseaux neuronaux, il arrive que même les développeurs de ces algorithmes soient incapables d'expliquer leur logique interne.

Lorsqu'un message est publié, même s'il a nécessité beaucoup de temps et d'efforts, l'algorithme peut décider qu'il est de faible qualité, le classer dans une catégorie inférieure et faire en sorte qu'il n'apparaisse jamais dans les flux d'amis choisis par l'algorithme. Dans ce paradigme, ni l'avis de l'utilisateur ni celui de ses amis ne comptent, l'algorithme a décidé et sa décision est définitive.

En outre, comme ces algorithmes sont appliqués à des millions, voire des milliards de personnes, les entreprises ou organisations manipulatrices ont tout intérêt à les désosser. Si elles parviennent à comprendre le fonctionnement de ces algorithmes, les entreprises peuvent les adapter pour donner la priorité à leur propre contenu afin qu'il apparaisse en tête du plus grand nombre possible de flux. Cette situation s'aggrave si les incitations financières du réseau social sont alignées sur celles de l'entreprise. Même si le réseau de médias sociaux lui-même est totalement bienveillant, cela restera toujours un problème.

Un dernier défaut de ces algorithmes est l'incitation des réseaux sociaux à vous garder accroché à leur produit. Cela signifie que les algorithmes sont optimisés pour afficher le contenu que vous aimez et cacher celui que vous n'aimez pas. Bien qu'utile avec modération, cela peut rapidement devenir dangereux si l'on privilégie la dopamine et l'attrait émotionnel à court terme plutôt que la santé mentale et le bien-être.

Qui choisit les modérateurs ?

La modération centralisée présente un problème fondamental, rarement discuté : L'idée qu'une tierce partie est nécessaire pour modérer le contenu des utilisateurs.

Pourquoi ne pouvons-nous pas décider de cela par nous-mêmes ? Pourquoi devons-nous être soumis aux caprices de modérateurs cachés et d'algorithmes opaques qui décident qui est autorisé et quel contenu est acceptable ?

Les mondes décentralisés n'ont pas besoin d'être structurés de cette manière. Les réseaux décentralisés ont le potentiel de répondre à l'intention initiale de l'internet : des mondes ouverts à tous, sans dirigeants mondiaux, dans lesquels chacun peut participer et modérer son propre domaine. Les utilisateurs choisissent à qui faire confiance, qui ignorer, et comment ordonner leur alimentation.

La solution : Un système de modération décentralisé qui s'adapte à tout le monde

Pour bénéficier de la meilleure expérience sociale possible, la modération doit être personnalisée. Les individus doivent pouvoir décider qui peut faire partie de leur monde et qui ne le peut pas. Il est impossible pour une entreprise de mettre en place des politiques approuvées par des millions de personnes et qui n'ont pas d'inconvénients ou de conséquences involontaires.

Cela ne signifie pas que les modérateurs mondiaux ne sont plus nécessaires. Ils sont toujours incroyablement utiles, mais ne sont plus obligatoires. Au lieu de cela, les modérateurs devraient être choisis (opt-in), laissant un individu, ou un groupe d'individus, choisir le modérateur de son "monde". Cela permet aux utilisateurs de bénéficier des services d'entreprises spécialisées dans la détection et l'élimination du spam, des réseaux de robots ou de l'astroturfing, sans être obligés de les utiliser.

Comment cela fonctionne-t-il ?

Dans la vie réelle, la confiance vient des amis et de la famille, des personnes auxquelles on fait déjà confiance pour aider à déterminer qui est digne de confiance et qui ne l'est pas. Lorsqu'un ami commence à fréquenter de mauvaises personnes, soit on essaie de l'en éloigner, soit on perd sa confiance en lui.

C'est exactement comme cela que fonctionne le nouveau système de confiance décentralisé. Un utilisateur évalue la fiabilité de certaines des personnes rencontrées en ligne, puis la confiance de toutes les autres personnes est calculée en fonction de ces évaluations. Dans cette implémentation, les évaluations de confiance doivent être publiques, afin que tout le monde puisse calculer la confiance des amis des amis. À l'avenir, un système de confiance plus privé pourrait être développé sur le même modèle.

La deuxième partie est un filtre qu'un utilisateur peut appliquer à son flux social pour cacher toutes les personnes dont l'indice de confiance est inférieur à un seuil particulier.

Il ne s'agit pas d'une spécification finale, mais d'une ébauche de la façon dont ce système peut fonctionner. Cet essai porte sur les raisons pour lesquelles nous devrions le construire et comment il pourrait fonctionner, plus que sur les détails exacts de la mise en œuvre.

Pour amorcer le système, l'utilisateur doit d'abord donner une note aux personnes en qui il a confiance ou dont il se méfie sur le réseau. Il peut s'agir de personnes connues dans la vie réelle ou non. Les notes peuvent être comprises entre -100 et 100. Cette note doit correspondre à la confiance que l'utilisateur accorde à ces personnes pour qu'elles publient un contenu similaire à leur spectre de contenu idéal, car ces notes façonneront le contenu vu sur le réseau social.

Lorsqu'un utilisateur rencontre de nouvelles personnes en ligne, il peut leur attribuer une note de +/- 1 en fonction du contenu individuel qu'il a posté. Pour les spammeurs ou les trolls évidents, il peut immédiatement leur attribuer une note négative.

Ainsi, alors que les éléments de contenu individuels peuvent être notés, la note de confiance est attribuée à une personne. Cela s'explique par le fait que la plupart des gens publient du contenu dans un spectre de contenu similaire. Cependant, il est important que la confiance soit également liée au contenu, de sorte que lorsqu'un utilisateur pose la question "Pourquoi mon ami se méfie-t-il de ce type ?", il peut voir le contenu exact qui a suscité sa méfiance.

Après avoir attribué quelques notes de confiance, l'algorithme calculera la fiabilité des amis des amis (à deux degrés de séparation) et même de leurs amis (à trois degrés de séparation). Pour ce faire, l'algorithme prend en compte toutes les personnes en qui l'utilisateur a confiance et toutes les personnes en qui il a confiance, puis multiplie les niveaux de confiance pour obtenir une note de confiance personnelle pour chaque personne. Même si un utilisateur ne note que dix personnes, que ces dix personnes en notent dix autres et que ces dernières en notent dix autres, l'utilisateur aura une note de confiance pour plus de 1000 personnes sur le réseau.

Lorsqu'une note de confiance est donnée, elle est fixe et n'est pas affectée par les notes des autres.

Les personnes dont un utilisateur se méfie n'ont aucun effet sur la note de confiance qu'il accorde aux autres. C'est exactement comme dans la vie réelle, où lorsqu'une personne rencontre quelqu'un qu'elle n'aime pas, elle ne se soucie pas de savoir qui sont ses amis ou ses ennemis. Cela empêche également les utilisateurs malveillants de jouer avec le système.

Désormais, au lieu de devoir bloquer individuellement les spammeurs, les trolls et les haineux de votre monde, dès qu'un ami de confiance attribue une mauvaise note à une personne, celle-ci est automatiquement masquée, ce qui facilite grandement la modération des trolls ou des spammeurs évidents.

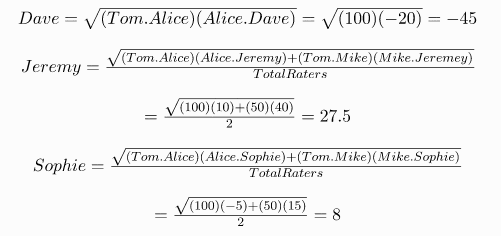

L'algorithme

L'algorithme général est le suivant : la cote de confiance de toute personne qui n'a pas déjà une cote définie est la racine carrée de la confiance d'un utilisateur envers un ami commun multipliée par la confiance de l'ami commun envers l'étranger. Dans le cas de négatifs, le négatif est ignoré lors du calcul de la racine carrée (il n'y a donc pas de nombres imaginaires). Lorsqu'un utilisateur a plusieurs amis communs, leurs scores sont additionnés avant la racine carrée et ce nombre est divisé par le nombre total d'évaluateurs (de sorte que quelqu'un qui est populaire n'est pas naturellement plus digne de confiance).

Il y a un petit défaut dans cet algorithme. Si un utilisateur a un ami "Alice" qui a une note de 10, et qu'elle a un meilleur ami "Bob" qui a une note de 100, le score de Bob sera de Racine Carré de (10)*(100)=31,6.

C'est bizarre car l'utilisateur ne fait pas tellement confiance à Alice, alors pourquoi ferait-il plus confiance à Bob qu'à elle ? Comme dans la vie réelle, si une connaissance amène un ami à une fête, peu importe à quel point il dit l'apprécier, il n'aura pas plus de confiance que cette connaissance.

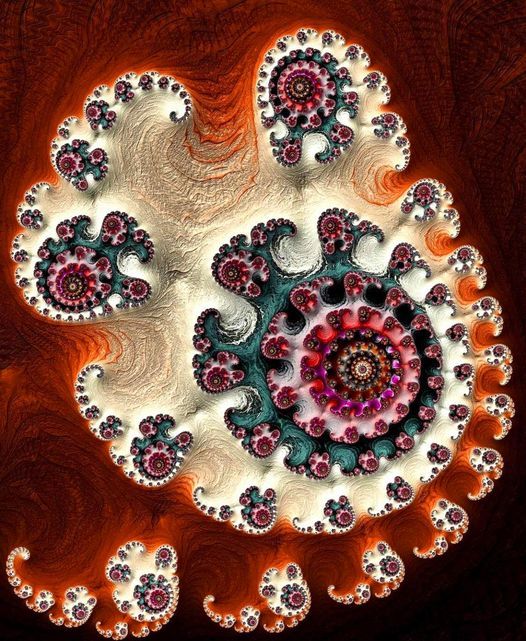

Voici une démonstration de ce système en action, avec des utilisateurs générés aléatoirement qui font confiance à d'autres utilisateurs à des niveaux aléatoires :

Le code source de cette démo est ouvert sur Github. Cliquez sur l'image pour l'essayer.

Vous pouvez ajuster le nombre total d'utilisateurs et les évaluations moyennes par utilisateur pour voir comment le système fonctionne lorsque davantage de personnes le rejoignent et l'utilisent. Vous pouvez également ajuster la profondeur, ou les degrés de séparation, pour laquelle les notes de confiance sont calculées.

Les flèches représentent le degré de confiance de chaque utilisateur envers l'utilisateur vers lequel elles sont dirigées. La couleur de chaque utilisateur représente la confiance que lui accorde l'utilisateur sélectionné (le bleu), calculée par l'algorithme décrit dans cet article. Le vert vif représente 100 % de confiance et le rouge vif -100 % de confiance, avec un gradient pour les scores intermédiaires.

Mise en œuvre technique

Ce système peut être mis en œuvre par tout réseau social open source. Il faudra ajouter un plugin de confiance qui permet aux utilisateurs de poster des "messages de confiance" contenant l'ID du contenu créé par un utilisateur et leur évaluation de cet utilisateur. Grâce à ces informations, l'algorithme peut calculer la cote de confiance de tous les utilisateurs en fonction des messages de confiance que chacun a publiés.

En ce qui concerne l'expérience utilisateur, ce plugin pourrait ajouter des boutons de vote à la hausse ou à la baisse à chaque élément de contenu qui augmente ou diminue la confiance dans l'utilisateur qui a publié ce contenu. Le filtre de confiance peut être une simple liste déroulante en haut à droite du flux qui, lorsqu'un niveau de confiance est choisi, tous les messages des utilisateurs dont la cote de confiance est inférieure à ce niveau seront masqués.

En termes de performances, la démo ci-dessus utilise un algorithme simple en JavaScript, et même celui-ci est capable de recalculer la confiance de plus de 100 000 personnes en quelques millisecondes seulement. Vous pouvez voir les benchmarks ici.

Cette méthode peut s'appliquer à des centaines de millions d'utilisateurs, car chaque utilisateur n'a besoin de calculer que les évaluations de quelques centaines ou dizaines de milliers de personnes. Comme il s'agit d'une source ouverte, cet algorithme peut être mis à jour et amélioré au fil du temps si de meilleures méthodes de calcul de la confiance sont découvertes. Un exemple de texte écrit de cet algorithme se trouve à l'annexe A.

Avantages supplémentaires de la confiance décentralisée

Choisissez vos propres modérateurs

C'est toujours une bonne idée que les grandes organisations deviennent des modérateurs, car elles ont plus de ressources et d'influence que les individus. La différence est que, dans un monde décentralisé, chacun peut choisir ses propres modérateurs. Imaginez un avenir où le New York Times dispose de son propre utilisateur "Balise de Confiance" sur la plateforme. Chaque fois qu'il fait état de fausses nouvelles ou de faux contenus, cette balise de confiance peut marquer le contenu et ceux qui le publient/créent à, disons, -10 de confiance.

Si un utilisateur fait confiance au New York Times, il peut lui attribuer une note de confiance de 50, par exemple, et il appliquera automatiquement ses notes de confiance à son flux social. C'est la même chose que de faire confiance à n'importe quel autre utilisateur.

Ces balises de confiance pourraient être mises en place par n'importe quelle entreprise de médias, par des sites web de détection de fausses nouvelles, ou même par des entreprises comme NetNanny qui souhaitent filtrer les contenus dangereux pour les enfants. Les gens peuvent faire confiance à n'importe qui et ces notes de confiance seront appliquées à leur flux. Ainsi, il n'est pas nécessaire d'avoir un grand réseau d'amis pour aider à filtrer le contenu, ces entreprises peuvent le faire si elles le souhaitent.

La confiance peut être liée à des messages, des images, des vidéos

Ce système de confiance ne doit pas nécessairement s'appliquer uniquement aux utilisateurs. Il peut être appliqué à des messages individuels ou à des éléments de contenu. Par exemple, sur Scuttlebutt, chaque élément multimédia est stocké sous forme de blob, où le nom du fichier est un hachage de son contenu (comme dans IPFS pour Astroport!!). Ce hachage est essentiellement une empreinte digitale de l'image, de la vidéo, de la chanson, sur ASTROPORT du MEDIAKEY sur le réseau.

Des sources de balise de confiance telle que Snopes ou https://captainfact.io, qui déboulonne les fausses informations, peut apporter leur notation. Dès lors que chaque média peut être identifiée sur le réseau par son empreinte (MEDIAKEY ipns et HASH ipfs), si un utilisateur s'abonne à la "balise de confiance", elle peut automatiquement signaler et filtrer ce contenu pour lui, même si cette image a été repostée 100 fois avant qu'il ne la voie. Cette méthode est parfaitement applicable aux contenus pornographiques ou violents dangereux pour les enfants.

Vous choisissez ce que la confiance signifie pour vous

Ce qui est intéressant dans ce système, c'est que l'utilisateur n'est pas obligé de faire confiance aux gens sur la base de leur sincérité. La confiance est un chiffre arbitraire qui peut être utilisé pour représenter tout ce que l'on aimerait voir plus souvent dans son monde social. Si un utilisateur souhaite que les notes de confiance soient basées sur des croyances partagées, la positivité ou même la proximité géographique, c'est à lui de décider.

Imaginez un monde où, au lieu d'avoir un seul profil social, chacun aurait un profil pour chaque sujet qui l'intéresse. On pourrait avoir un profil pour la programmation, pour la politique, pour les jeux, pour la décentralisation, etc. Si cela devient courant, la confiance que l'on accorde à quelqu'un peut être directement liée à son domaine d'expertise. Souvent, la confiance ne repose pas sur la personne, mais sur la certitude que l'on a qu'elle connaît le sujet dont elle parle.

Une autre solution consisterait à mettre en œuvre le système de manière à ce que les personnes aient plusieurs notes de confiance, chacune étant étiquetée par sujet. Cependant, cela ajouterait beaucoup plus de complexité, notamment pour identifier à quel sujet appartient chaque message.

Créer à nouveau de petites communautés

La plupart du temps, les amis sont choisis par sérendipité. Il a été démontré que le secret de l'épanouissement d'une amitié réside dans de multiples rencontres aléatoires. L'une des raisons pour lesquelles les gens se font rarement des amis via les principaux réseaux sociaux (Twitter, Facebook, Reddit, etc.) est qu'ils sont si vastes et dispersés que les gens rencontrent rarement deux fois la même personne s'ils ne sont pas déjà amis.

Imaginez que votre flux social affiche toutes les personnes que vous suivez, ainsi que toutes les personnes qu'elles suivent, avec leur rang basé sur des notes de confiance. Vous pourriez découvrir de bons amis d'amis que vous n'avez jamais rencontrés et qui publient des contenus que vous aimez vraiment. Au fil du temps, vous pourriez commenter leurs publications, contribuer à la conversation et, éventuellement, nouer une relation.

Le système de confiance permettrait aux meilleurs amis d'amis d'apparaître dans le flux de l'utilisateur plus souvent qu'un oncle fou aléatoire, des messages de groupes ou même des connaissances à peine connues. Cela pourrait conduire à de nouvelles connexions et à de nombreuses amitiés étonnantes avec des personnes qui n'étaient auparavant pas en contact. Plus il y a d'intérêts et de personnes en commun, plus les utilisateurs se verront en ligne et plus ils auront de chances de se connecter.

C'est la modération à l'échelle d'Internet.

L'avenir sera rempli d'IA et de bots qui créeront des centaines de milliers de comptes afin de prendre le contrôle des réseaux sociaux. Avec la confiance décentralisée, il suffit d'un ami ou d'une "balise de confiance" pour remarquer ces bots et s'en méfier. Il doit être possible de faire évoluer la modération à un niveau tel qu'elle puisse combattre des milliers, voire des millions, de faux utilisateurs et de bots. Cela ne peut pas se faire en ayant des modérateurs désignés, cela ne peut se faire que si tout le monde participe à la modération d'une partie du monde.

Les inconvénients de la confiance décentralisée

Il existe des inconvénients potentiels à ce système. Comme pour toute chose, quand on donne de la liberté aux gens, certains vont mal l'utiliser. Ce n'est pas grave. De toute façon, on ne devrait pas dire aux gens ce qu'ils doivent faire.

Le premier problème évident est la création de chambres d'écho ou de cultes en ligne, où au lieu de choisir la vérité et de rechercher les meilleures informations, les gens font confiance à ceux qui confirment leurs croyances existantes.

Ce problème peut être quelque peu atténué par la possibilité de définir un filtre de confiance à un niveau bas, même négatif, afin de voir des messages et des opinions auxquels on n'est généralement pas exposé. Là encore, c'est à l'utilisateur final de décider s'il souhaite s'exposer à des opinions divergentes ou non.

C'est à chacun de déterminer ce qui lui convient le mieux. Bien sûr, on peut espérer qu'ils fassent les bons choix, mais ce n'est pas à la société de sauver les gens d'eux-mêmes. Il est de loin préférable de disposer de cette liberté et du pouvoir d'en user ou d'en abuser, plutôt que de permettre aux entreprises de construire la chambre d'écho derrière des portes closes.

Conclusion

La mise en œuvre sera open source et ouverte à toute participation. La mise en œuvre a déjà commencé, mais il y a beaucoup de travail à faire. Si quelqu'un a entendu parler de quelqu'un qui construit quelque chose de similaire, il serait merveilleux de le rencontrer pour que cette idée puisse se concrétiser.

C'est excitant de penser aux possibilités que ce système pourrait apporter. Il est possible de créer des fils de conversation plus stimulants sans que les trolls n'essaient de gâcher le plaisir. Avec l'état actuel de l'Internet social, c'est difficile, mais c'est quelque chose qui vaut la peine d'être fait.

Annexe A : Exemple de système de confiance

Prenons un exemple, en commençant par Tom.

Tom a une meilleure amie, Alice, à qui il fait confiance à 100 %.

Tom a également un ami, Mike, en qui il a une confiance de 50 %.

Alice connaît un certain Dave, qui est un menteur compulsif et lui accorde une confiance de -20 %.

Alice a un collègue de travail, Jeremy, qui est un type bien, mais elle ne le connaît pas bien et lui accorde une confiance de 10 %.

Alice a une collègue de travail, Sophie, qui partage constamment de fausses indignations, mais qui est autrement une bonne personne, à qui elle accorde sa confiance à -5.

Mike est le meilleur ami de Jeremy et lui fait confiance à 40.

Mike connaît Sophie, l'aime bien et lui fait confiance à 15 %.

Dave a un meilleur ami, Barry, en qui il a confiance à 100 %.

Sophie a une meilleure amie, Emily, à qui elle fait confiance à 100 %.

Bien que Tom n'ait évalué que 3 personnes, le logiciel de confiance va maintenant calculer ses notes de confiance personnalisées pour les 7 personnes présentes :

Tout d'abord, il y a les amis immédiats, si vous avez évalué quelqu'un, c'est l'évaluation fixe pour cette personne, elle n'est pas influencée par quelqu'un d'autre :

Alice=100

Mike=50

Ensuite, les amis secondaires :

Ensuite, les amis tertiaires :

Barry n'est pas noté car Tom.Dave < 0

Il y a plusieurs choses intéressantes qui se passent ici. Tout d'abord, Sophie se retrouve avec une cote de confiance légèrement positive, même si Alice, la meilleure amie de Tom, estime qu'elle partage trop de fausses indignations. Cela s'explique par le fait que Mike lui fait toujours confiance. Si Tom remarque qu'elle partage beaucoup de fausses informations, il peut soit la noter lui-même, ce qui signifie que les notes de ses amis ne s'appliquent plus, soit baisser la note de Mike, car il devient évident que ce dernier ne se soucie pas autant de la véracité des informations.

Nous voyons également que l'évaluation de Barry n'est pas calculée du tout (elle est donc égale à 0 par défaut). En effet, si nous ne faisons pas confiance à quelqu'un, nous ne faisons pas non plus confiance à ce qu'il a à dire sur la réputation des autres, de sorte que le système ne peut pas être manipulé par des acteurs malveillants. De même, si Tom évaluait Sophie avec un chiffre négatif, son évaluation d'Emily ne serait plus valable et Emily aurait la note par défaut de 0.

Enfin, nous constatons que l'évaluation d'Emily est plafonnée au même niveau que celle de Tom.Sophie, car nous ne pouvons jamais évaluer les amis d'amis plus haut que l'ami commun.

Toutes les personnes ci-dessus sont maintenant en pleine discussion sur la politique et Tom peut voir cette discussion dans son flux. Comme Tom veut être bien informé sans que des menteurs soient impliqués, il règle son niveau de filtre de confiance sur 10, de sorte que toutes les personnes ayant une note inférieure à 10 seront masquées. Cela permet à Tom de filtrer son monde sans investir beaucoup d'efforts dans le processus. Dans ce flux, il ne verra que les messages d'Alice, Mike, Jeremy et Emily. Les messages de Sophie, Dave ou Barry seront cachés.

SOURCE https://adecentralizedworld.com/2020/06/a-trust-and-moderation-system-for-the-decentralized-web/

TRADUCTION https://www.deepl.com/

"Dans un univers infini de rotations en fractal, comment définir le centre ? Chaque point est le centre. Vous êtes le centre de l'univers observant l'univers depuis votre propre centre. Quelque soit le centre d'observation que vous choisissez dans cet univers fractal, ce point devient le centre duquel vous observez l'univers. Ce point devient statique. Pourquoi statique ? Parce qu’au cœur de ce point, toutes les rotations (spin) de l'univers s'annulent. Nous avons besoin d'immobilité comme cadre de référence pour définir une rotation... et c'est ainsi que la singularité se crée. La singularité, c'est le centre de votre expérience de l'univers. C'est l'espace calme duquel vous observez l'univers." Nassim Haramein

Un système de confiance

et de modération pour le Web décentralisé